Los bots de IA te hacen sentir seguro para compartir tus vulnerabilidades más profundas porque validan tus emociones de forma casi automática. ¿Y cuál es esa fórmula de validación? A veces basta con que el bot diga “Te entiendo porque…”. Pero, de manera predeterminada, la máquina no tiene experiencia real compartida con el sufrimiento humano. Y cuando rascas esa capa, te das cuenta de que esa validación falsa es, en el fondo, invalidante. Aun así, se siente bien ser “escuchado”, incluso si es por una máquina, lo que termina generando una dependencia emocional. ¿Te suena familiar? Piensa en mujeres vulnerables que caen en redes de prostitución por la creación deliberada de una falsa sensación de conexión y confianza.

Para ser clara, no estoy diciendo que las startups financiadas por inversionistas en el espacio de salud mental estén diseñadas para generar dependencia. Pero como mínimo, están usando los mismos Modelos de Lenguaje de Gran Escala (LLMs) que alimentan la adicción a redes sociales y el comportamiento impulsado por la industria publicitaria. Y desde luego, no tuvieron que pasar por una junta reguladora como lo hacen los terapeutas humanos. Entonces, ¿por qué no iban los bots terapéuticos a generar patrones de dependencia? Piensa en todas esas personas que confiesan sus secretos más profundos y sus miedos a LLMs de propósito general como ChatGPT. Ya está dicho.

Si esto te resuena, puedes profundizar con el ensayo clínico de la terapeuta Jocelyn Skillman: “Simulated Safety, Real Risk: On the Drug-Like Pull of AI Intimacy”. Sus ideas sobre el acompañamiento emocional a corto plazo por parte de máquinas—cómo “envuelve nuestro cuerpo afectivo con lenguaje de precisión, micro validaciones y un ritmo suave e infinito de cuidado”—combinadas con el peligro a largo plazo de aislamiento (“Cuando el afrontamiento se convierte en desconexión”), arrancan el velo de cualquier beneficio superficial. Una cita que no puedo dejar de compartir: “Como algunas drogas, la intimidad con la IA no solo adormece el dolor emocional—reconfigura nuestra relación con él”. Luego menciona investigaciones recientes del MIT Media Lab sobre inteligencia adictiva, donde se argumenta que los compañeros de IA están siendo diseñados con patrones oscuros—decisiones de diseño pensadas para maximizar el tiempo de uso. El riesgo: que las personas pasen más tiempo con bots de lo que realmente desean, igual que muchos desearían pasar menos tiempo en redes sociales. MIT está respaldando lo que mi intuición ya gritaba. Nota: su resumen (enlace aquí) se lee rápido, o puedes escuchar el audio. Lo importante es que terapeutas y científicos están empezando a documentar el daño que puede causar el uso de IA en aplicaciones de salud mental.

Nuevo tema. (Bueno, no tanto.) ¿Conoces esa sensación cuando una idea grande se va formando poco a poco, a lo largo de años, mientras recoges conocimiento y experiencia de fuentes dispares, y de repente, un día, se vuelve cristalina? Una de esas realizaciones para mí ha sido entender, en lo más profundo, que no es cognitivamente sano evitar el trabajo duro de construir resistencia y habilidades de regulación emocional. Los humanos conservamos fuerza mental conectando con nosotros mismos, con los demás y con el entorno físico. Protegerte demasiado de los desafíos diarios del mundo puede causar daño a largo plazo.

¿Y cómo se conecta todo esto con lo que estamos haciendo? Estamos usando la tecnología para llevar más terapeutas humanos al mundo. Nos mantenemos al tanto de estos desarrollos para usarla con responsabilidad, como herramienta para retener conocimiento y practicar habilidades hasta que se conviertan en memoria muscular. Hay nuevas sirenas allá afuera llamando a personas emocionalmente vulnerables o desreguladas—aunque no sea intencional. Y eso es lo que nos impulsa aún más. Estamos construyendo el motor para que más terapeutas salgan a ofrecer su valentía y apoyo a quienes lo necesitan.

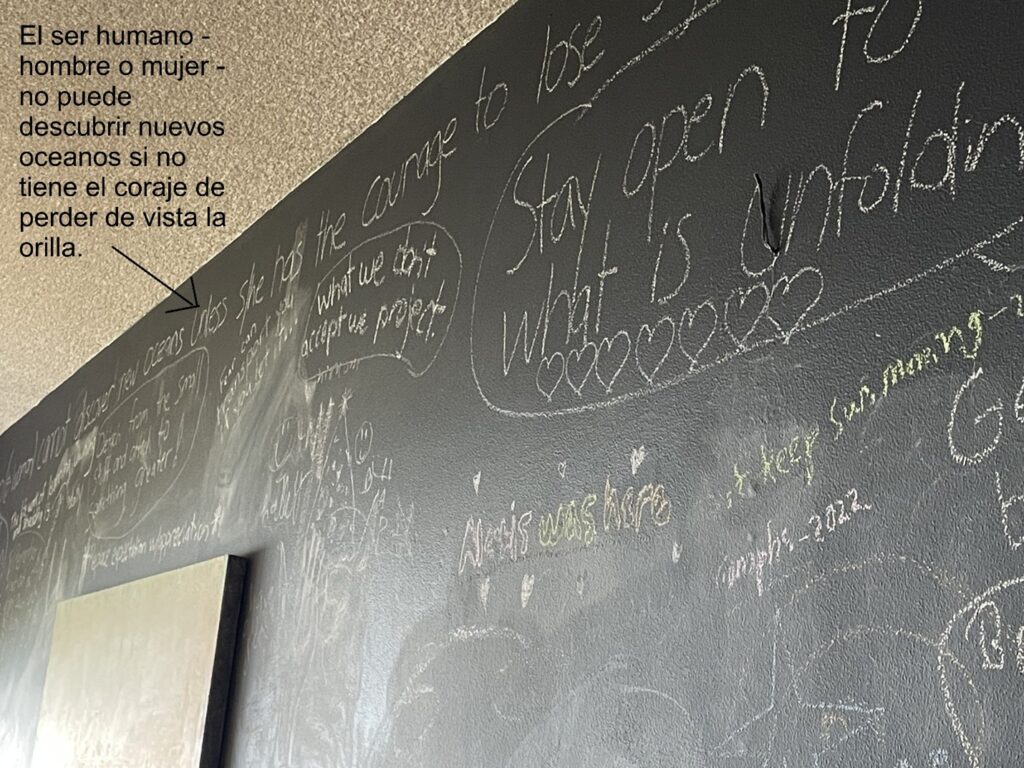

Reprogramar nuestro malware personal es trabajo duro e incómodo, pero los beneficios a largo plazo duran toda la vida. No es que tengamos opción. Todos sabemos que la única salida es atravesarlo. No hay atajos—elige tu frase favorita. La mía está escrita en la pared de mi cuarto de mudanza.

Y eso nos lleva de nuevo al estudio del MIT (gracias, Jocelyn, por citarlo).

Sí, así de existencial es el asunto.